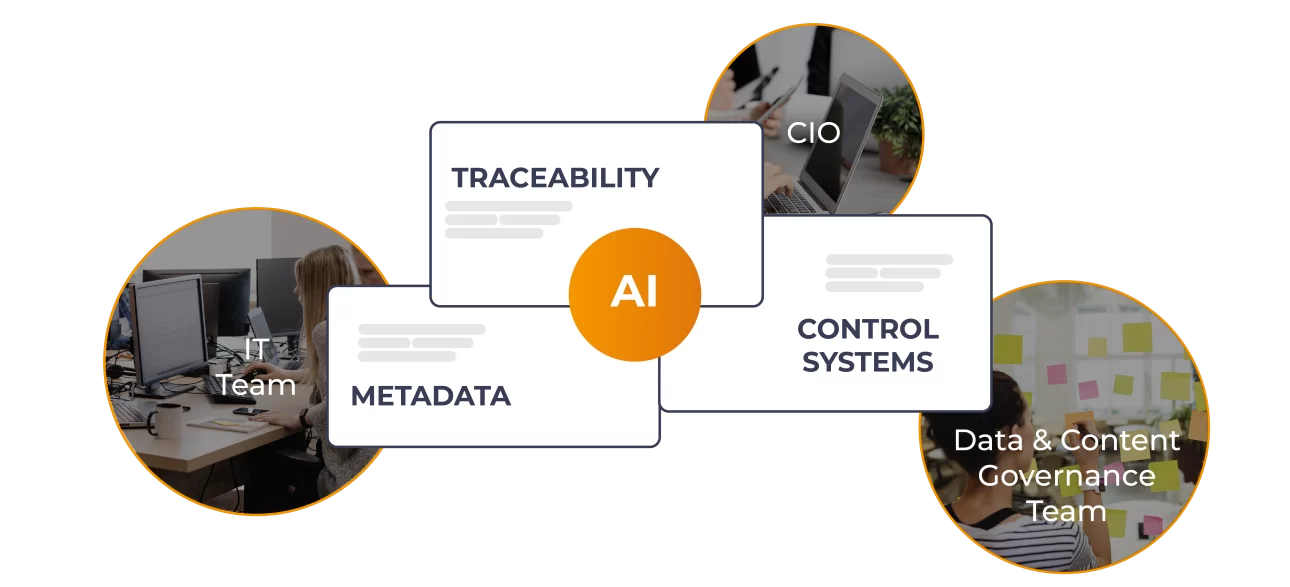

L’AI Act è la legge europea che regola l’uso dell’intelligenza artificiale per livelli di rischio. Stabilisce cosa è vietato, quando servono requisiti più stringenti e introduce obblighi di trasparenza per i contenuti generati o modificati dall’IA. Riguarda in primo luogo chi costruisce, integra e governa piattaforme e processi digitali in azienda: team IT, CIO e responsabili di data & content governance. Per loro, gli aspetti operativi più importanti sono la tracciabilità dei contenuti generati dall’intelligenza artificiale, la qualità dei metadati e un sistema di controllo leggibile che documenti come l’AI viene utilizzata.

La legge è già in vigore, ma adesso entrano in gioco le regole più operative: informare ed etichettare i contenuti generati dall’AI, rendere tracciabile la loro provenienza con metadati coerenti, scegliere in modo consapevole i modelli di uso generale (GPAI) e e mantenere registri delle attività (log) che dimostrino come l’AI opera nel quotidiano.

In questo articolo trovi, in modo pratico: cosa cambia per etichette e watermarking dei contenuti creati dall’AI, quali metadati e log servono per dimostrare la provenienza e l’audit trail, come impostare monitoraggio e controllo umano, cosa prevede l’AI act italiano e quali criteri seguire per scegliere i modelli di intelligenza artificiale più adatti alla tua azienda.

L’AI Act europeo parte da un’idea semplice: non tutte le tecnologie di intelligenza artificiale sono uguali. Ad esempio, un chatbot per il servizio clienti non può avere le stesse regole di un sistema che valuta i curriculum per le assunzioni. Per questo la normativa divide i sistemi di IA in categorie di rischio crescente. Ogni categoria ha obblighi specifici e, soprattutto, date precise entro cui essere conformi. La legge si applica a chi usa questi sistemi nelle proprie aziende, non solo ai fornitori delle tecnologie, quindi sei tu responsabile di rispettare le regole.

Ecco il calendario completo con i relativi ambiti d’uso:

La vera sfida non è solo rispettare le scadenze dell’AI Act, ma costruire una governance dell’intelligenza artificiale che rafforzi la fiducia dei clienti. Quando un’azienda deve etichettare le proprie immagini promozionali o i contenuti del sito come “generati artificialmente”, rischia di comunicare una percezione di minore autenticità e cura. Chi gestisce contenuti digitali e dati ha l’opportunità di anticipare questi scenari, organizzando fin da subito processi, responsabilità e controlli strategici che evitino compromessi tra compliance e reputazione aziendale, trasformando l’obbligo normativo in vantaggio competitivo.

L’AI Act introduce obblighi di trasparenza e marcatura: gli output devono essere contrassegnati in modo chiaro, che siano testi, immagini, audio o video.

I deepfake (contenuti dove l’IA sostituisce il volto o la voce di una persona con quelli di un’altra) devono essere etichettati e, quando tecnicamente possibile, dotati di una marca digitale (watermark) che le macchine possano riconoscere. Questo aiuta a tracciare il contenuto lungo tutto il suo ciclo di vita, dalla creazione alla distribuzione.

Per accompagnare l’adozione, la Commissione ha pubblicato il General-Purpose AI Code of Practice (10 luglio 2025) e Linee guida per chiarire quando e come si applicano gli obblighi ai fornitori di GPAI (31 luglio 2025). Il Codice non sostituisce la legge, ma è uno strumento volontario per dimostrare conformità; le linee guida precisano scopo e aspettative operative.

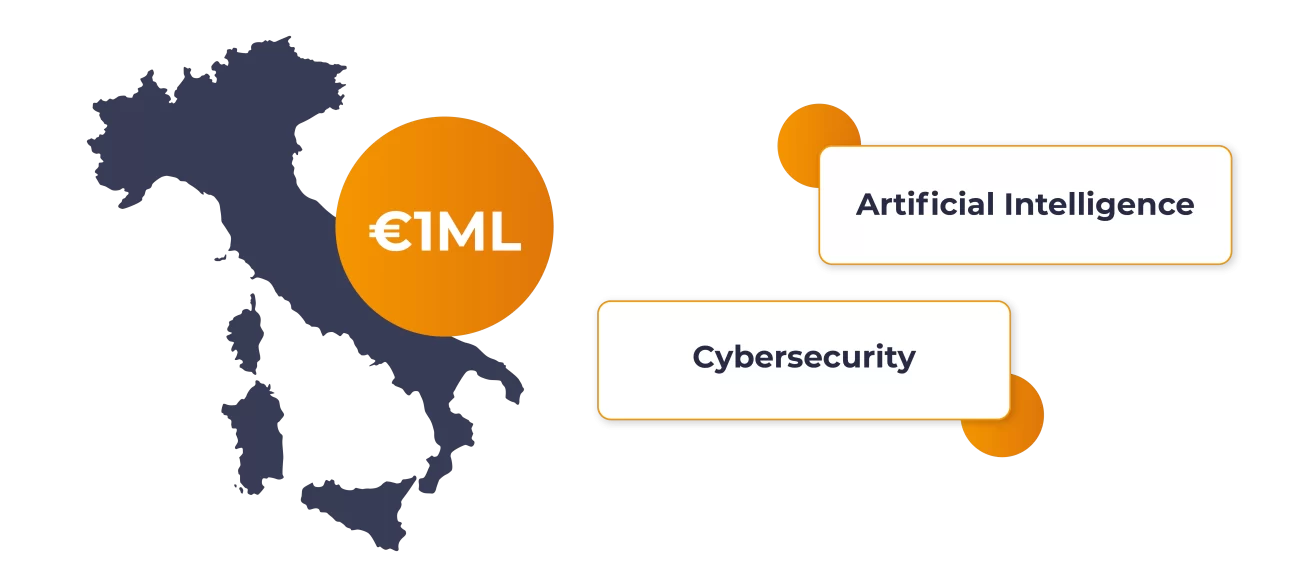

A settembre 2025 l’Italia ha approvato una legge nazionale che affianca l’AI Act con misure di coordinamento e vigilanza, incaricando l’Agenzia per l’Italia Digitale (AgID) e l’Agenzia per la Cybersicurezza Nazionale (ACN) dell’attuazione della normativa. È previsto anche un fondo da 1 miliardo di euro per sostenere AI e cybersecurity nel Paese. Per le imprese, questo si traduce in referenti chiari, controlli rafforzati e maggiore attenzione a trasparenza, tracciabilità e supervisione umana nei settori sensibili.

Nei casi d’uso più sensibili, il regolamento richiede documentazione e registrazione degli eventi, ossia tracce operative che un sistema di IA registra lungo il suo ciclo di vita, come l’avvio o la conclusione di una esecuzione. Senza metadati omogenei su origine, trasformazioni e versioni dei contenuti, diventa difficile garantire accountability, indagare incidenti o risalire all’origine dei dati. La provenienza non è un’etichetta aggiuntiva, ma un requisito fondamentale: i contenuti devono includere le informazioni necessarie fin dal momento della creazione, così che la trasparenza sia nativa e non aggiunta successivamente.

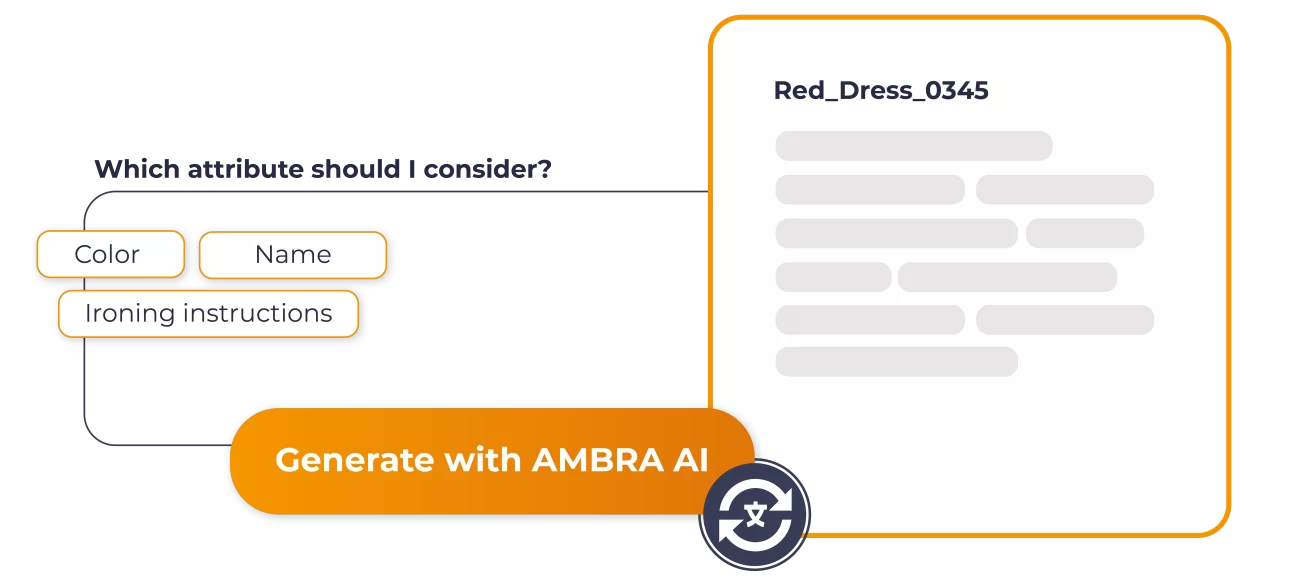

In questo contesto, AMBRA AI, l’intelligenza artificiale nativa di THRON Platform, aiuta a semplificare l’adeguamento all’AI Act e a recuperare tempo automatizzando i passaggi ripetitivi fin dal primo caricamento in piattaforma. THRON Platform fornisce la struttura con campi e template, tassonomie coerenti e versioning centralizzati. AMBRA AI lavora dentro questa struttura:

Il risultato è meno lavoro ripetitivo, meno errori e una pubblicazione più veloce. Così ogni contenuto entra in piattaforma con un set coerente di metadati, pronto ad accogliere etichette e avvertenze per i contenuti sintetici e a essere tracciato lungo tutto il ciclo di vita. Questo riduce lavorazioni manuali, rende i contenuti più rintracciabili e facilita la conformità.

Alla qualità dei metadati va affiancata la tracciabilità operativa. La legge prevede registri degli eventi (log) e monitoraggio continuo per i sistemi ad alto rischio; chiede inoltre ai deployer di conservare i log “per un periodo appropriato” per indagini, audit e miglioramento continuo. In sostanza: senza uno storico verificabile delle esecuzioni, la conformità resta solo teorica.

Il nuovo Automation Studio di THRON offre un centro di controllo unico per disegnare, attivare e monitorare le automazioni. Visualizza le automazioni disponibili con stato e descrizione, centralizza la configurazione, mantiene lo storico delle esecuzioni con log consultabili, rispetta i permessi per ruolo e invia notifiche in caso di errore, producendo un audit trail leggibile per controlli interni ed esterni.

Per chi integra modelli di uso generale (GPAI), la Commissione Europea ha pubblicato un Codice di Condotta volontario e Linee guida che spiegano cosa documentare e come farlo: trasparenza sui dati di addestramento, rispetto del copyright, gestione dei rischi sistemici.

Il Codice include anche modelli pratici, come il Model Documentation Form, utili nelle valutazioni dei fornitori. Le regole sui GPAI sono entrate in vigore dal 2 agosto 2025: inserire questi requisiti in RFP e contratti riduce incertezze e tempi di adeguamento.

Cos’è l’“EU AI Act” in poche parole?

È la legge europea che regola l’IA dividendola per livelli di rischio: prevede trasparenza, controlli per i casi più delicati e regole specifiche per i GPAI. È già in vigore, con applicazione scaglionata tra 2025 e 2027.

Quando devo etichettare un contenuto come generato dall’IA?

Quando un output è sintetico (cioè creato direttamente da un’Intelligenza Artificiale) o manipolato e può sembrare reale. Serve un’etichetta chiara e, dove tecnicamente fattibile, un watermark leggibile da software e piattaforme. Prevedere questi passaggi nei metadati riduce i rischi di errore.

Se uso un modello “general-purpose” (GPAI), cosa devo fare oggi?

Garantire documentazione, istruzioni d’uso, conformità copyright e pubblicare una sintesi delle fonti di training. Se il modello supera determinate soglie di capacità (rischio sistemico), servono misure aggiuntive di valutazione e mitigazione del rischio.

I log sono obbligatori anche per chi “deploya” il sistema?

Sì: i deployer devono mantenere i log generati dai sistemi ad alto rischio per un periodo appropriato, supportando tracciabilità e investigazioni. I fornitori devono predisporre sistemi che registrino automaticamente gli eventi.

Cosa comporta l’“AI Act italiano” per le aziende?

Stabilisce autorità di coordinamento (AgID, ACN), introduce tutele e sanzioni per abusi come i deepfake dannosi e rafforza la richiesta di trasparenza e supervisione umana. Per le imprese, significa processi tracciabili e referenti chiari.

Che relazione c’è tra AI act e “AI act italiano”?

Il quadro europeo è direttamente applicabile, mentre quello italiano si concentra su coordinamento, vigilanza e sanzioni specifiche, allineando autorità e responsabilità. Per le aziende, cambia l’operatività dei controlli e la collaborazione con i regolatori.

Come mi aiutano metadati e automazioni “in regola”?

Metadati coerenti e un audit trail leggibile sono la base probatoria della conformità; una console con log e storico esecuzioni rende i processi dimostrabili senza rallentare l’operatività.